Vous savez comment ça se passe quand vous voulez tester une nouvelle application serveur ? Vous ne voulez pas la mettre sur votre OS hôte, pour ne pas risquer de mettre le bazar sur votre ordi, surtout si c’est une beta. Vous la mettriez bien sur une machine virtuelle, mais il y en a déjà plein, vous ne savez pas trop sur laquelle ça posera le moins de problèmes de compatibilité, etc. Et puis il y a toujours le problème de dépendances multiples (voir par exemple http://gouigoux.com/blog-fr/?p=1036).

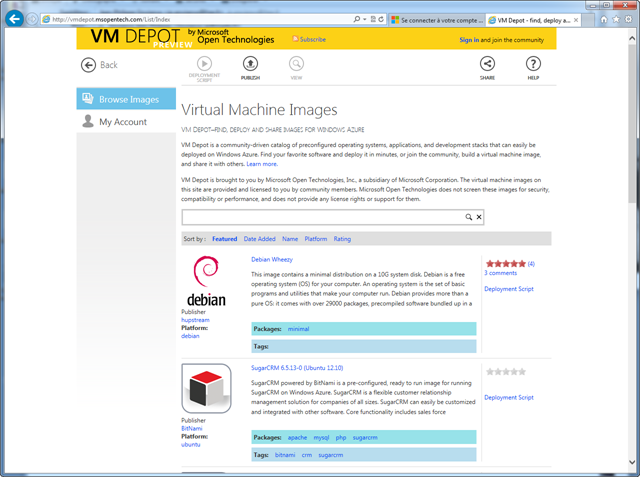

Bref, l’idéal serait de disposer d’images virtuelles avec tout ce qu’il faut dessus, déjà préinstallées par des personnes expertes du serveur en question, et qu’on pourrait juste instancier quand on a besoin de tester… Eh bien, ça existe ! Vous avez tout ce qu’il faut sur VMDepot (http://vmdepot.msopentech.com/)

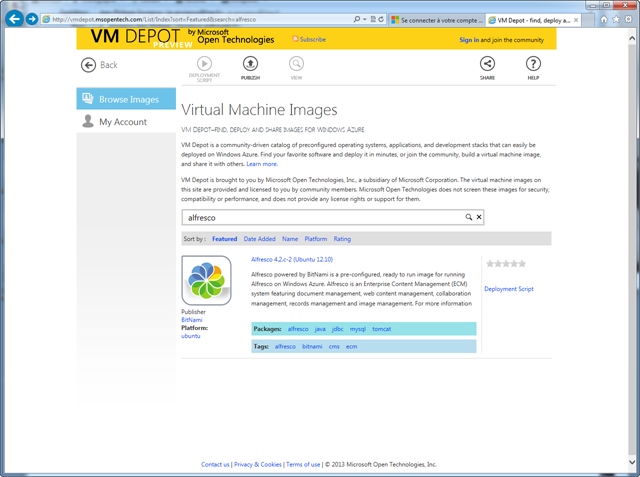

Prenons un exemple : je voudrais un Alfresco installé sur un Ubuntu. Une petite recherche sur le site et je trouve ce qu’il me faut :

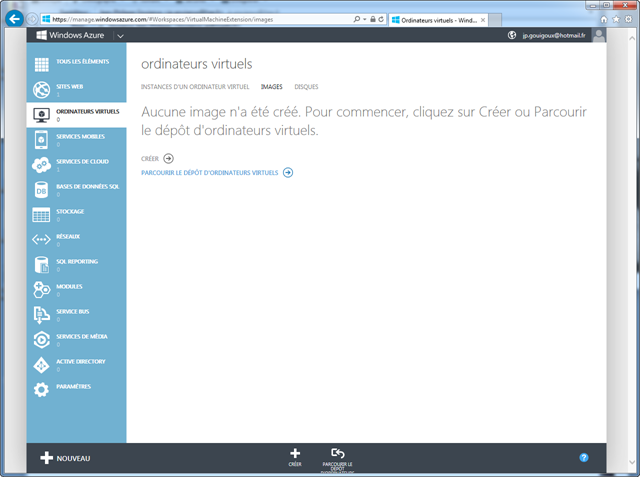

Pour la mettre en place sur votre compte Azure, ça peut difficilement être plus simple que les quelques manipulations ci-dessous. Après s’être connecté, dans la section Ordinateurs virtuels, on se place dans l’onglet Images, et on lance la commande Parcourir le dépôt d’ordinateurs virtuels.

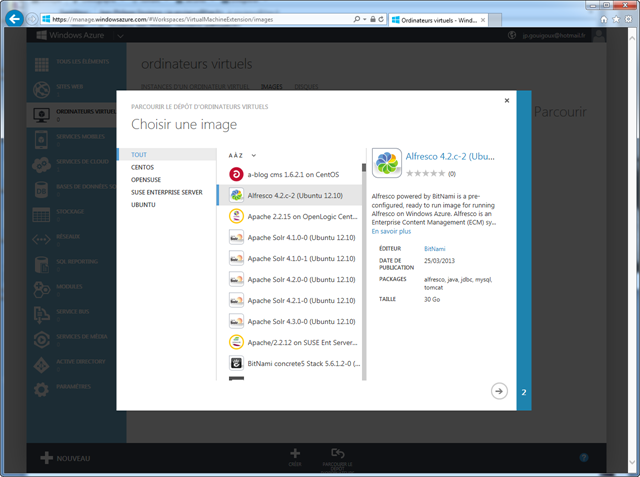

Ca donne accès à une liste où on retrouve justement les fameuses images virtuelles prêtes à l’emploi, et où on peut donc retrouver notre fameuse image Alfresco :

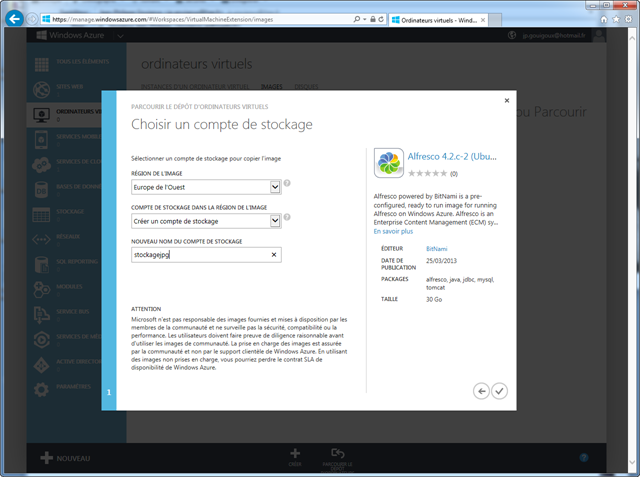

Ensuite, on choisit la région et le compte de stockage. Le compte de stockage est nécessaire parce qu’il faut stocker le fichier correspondant à l’image virtuelle dans notre compte Azure avant de pouvoir l’utiliser comme disque principal d’une machine virtuelle.

Après quelques minutes – allez, un quart d’heure – pour la recopie de l’image, vous êtes prêt à la valider. Bon, je n’ai pas bien compris (ni cherché en détail) à quoi servait cette étape de validation, mais j’imagine que ça permet de vérifier le checksum avant de la considérer comme fiable pour créer une machine virtuelle.

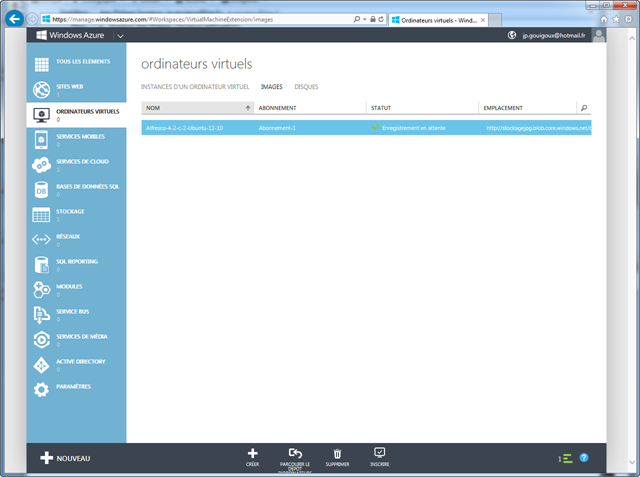

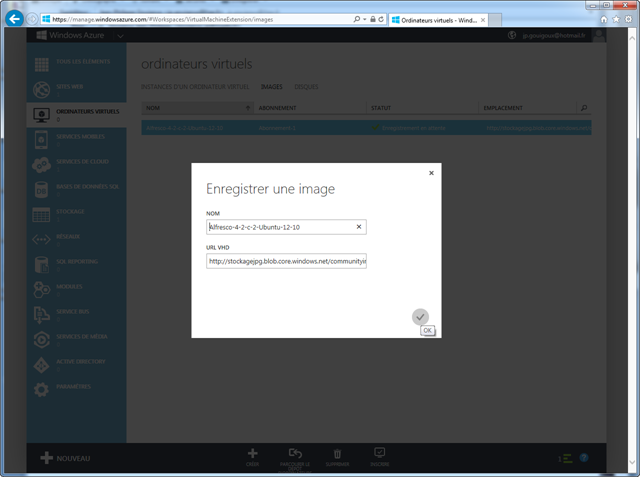

On clique donc sur le bouton Inscrire en bas de l’interface et on valide l’enregistrement :

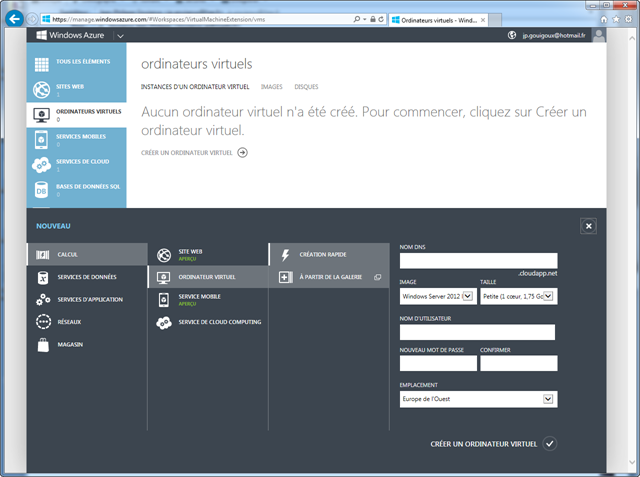

Une fois cette étape passée (quelques secondes), nous pouvons passer à la création de la machine virtuelle proprement dite, en choisissant dans l’assistant de créer une machine virtuelle à partir de la galerie :

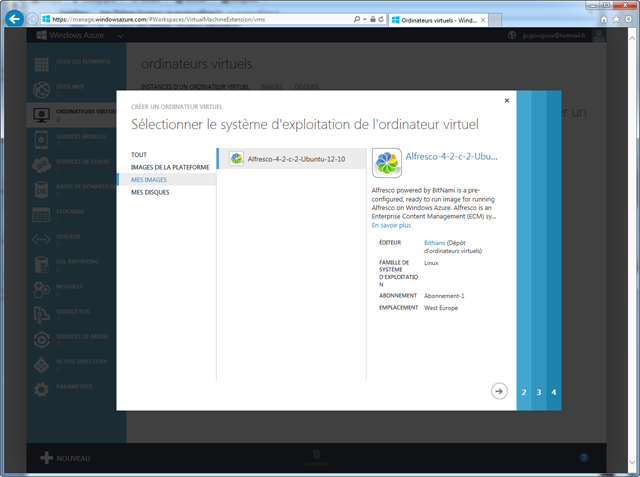

En fait, l’expression n’est pas très bien choisie car il faut ensuite changer à nouveau de choix pour sélectionner Mes images, et voir le disque virtuel que nous avons copié :

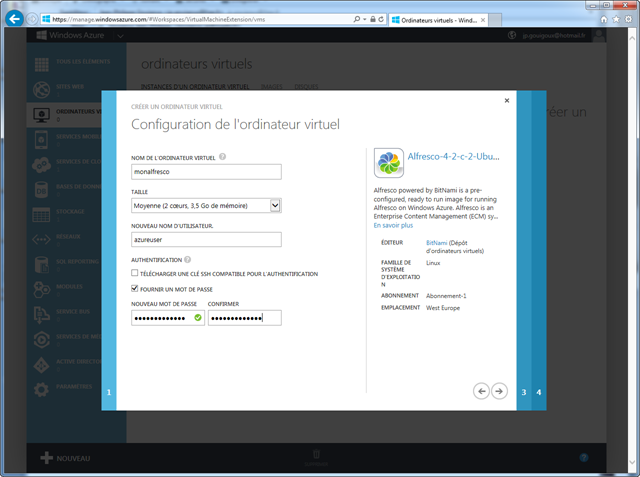

En deuxième étape, on choisit le nom de l’ordinateur virtuel, et le type de machine qu’on souhaite. Les informations d’authentification qui sont demandées sont celles qui serviront pour se connecter en SSH sur l’ordinateur. On peut utiliser un certificat / un mot de passe. Pour une machine de test, on ne se cassera pas trop la tête, un mot de passe suffira :

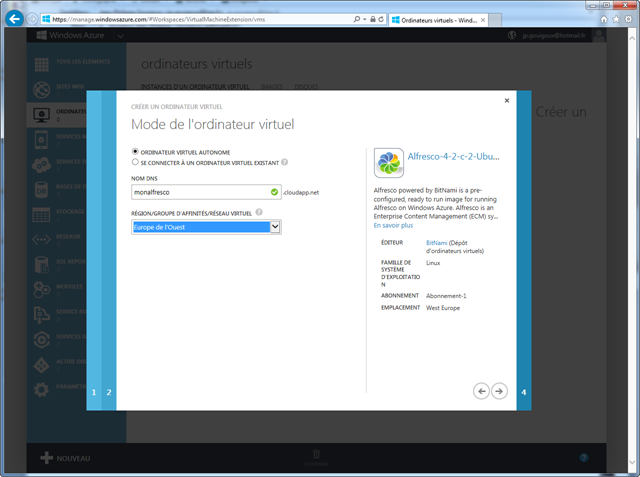

A l’étape suivante, on donne un nom DNS pour accéder à l’ordinateur et un groupe d’affinité. Le groupe d’affinité est un ensemble de machines virtuelles ou d’applications qui se trouvent toujours dans la même zone géographique, pour améliorer les performances. Si on spécifie juste une région Azure, on n’associe pas de groupe d’affinité.

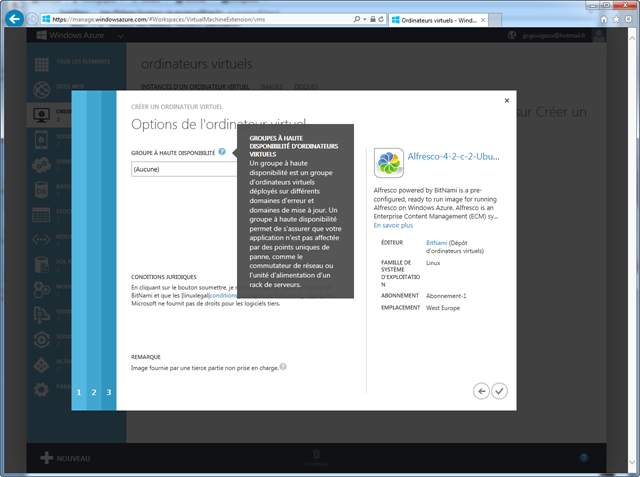

Pour la quatrième et dernière étape, je laisse la documentation embarquée expliquer à quoi ça sert. Là encore, vu qu’il s’agit juste d’une machine de test, on ne se cassera pas la tête avec un groupe à haute disponibilité…

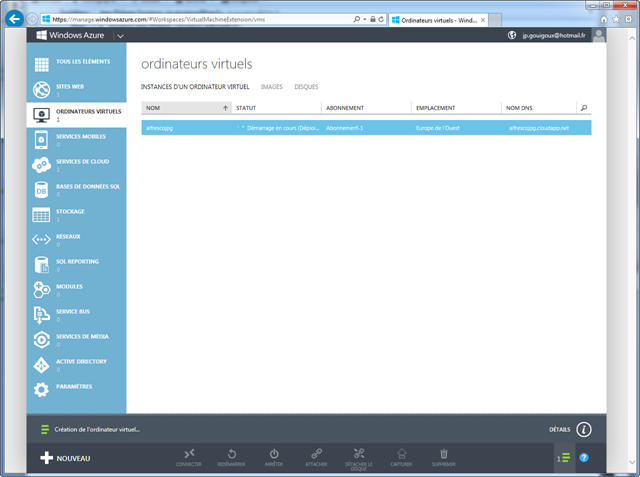

Une fois validée la dernière étape, on doit attendre le déploiement et le démarrage de la machine, qui prend quelques bonnes minutes :

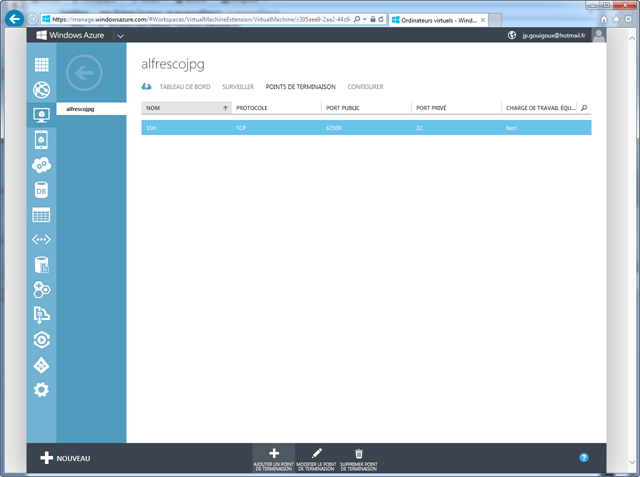

Il nous reste un dernier petit détail à régler, à savoir les réglages d’accès réseau. On va donc rajouter un point de terminaison :

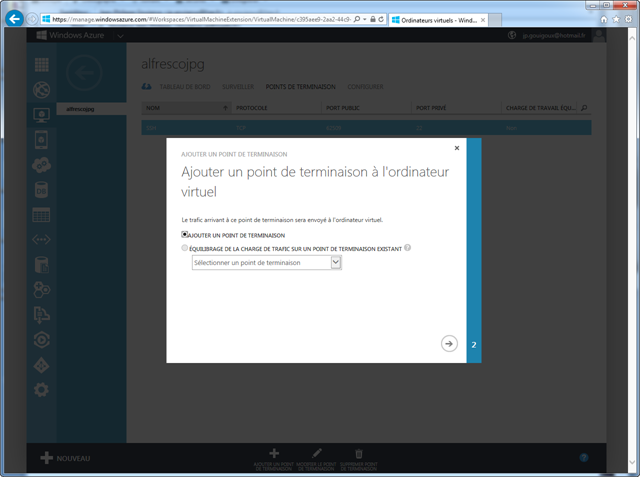

Dans l’assistant qui apparait, on utilise le premier choix :

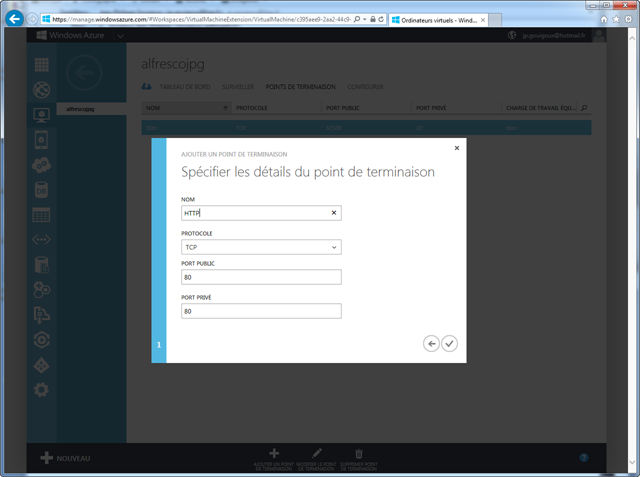

Puis on donne les caractéristiques d’une ouverture du protocole HTTP sur le port 80 à l’externe :

Là encore, ça prend un peu de temps (un peu moins d’une minute), mais une fois arrivé à cette étape, on a notre fameuse machine :

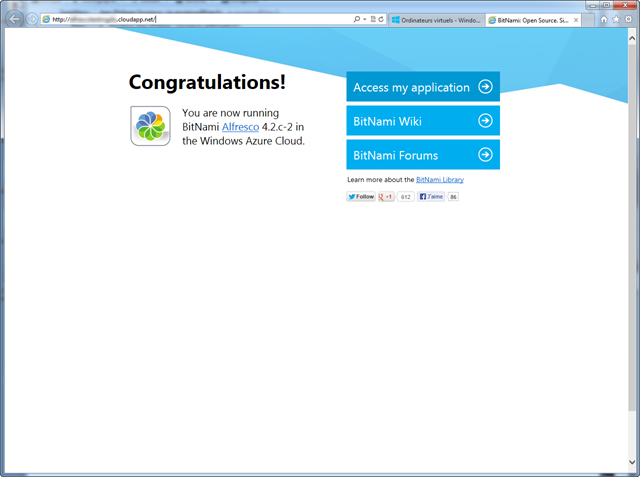

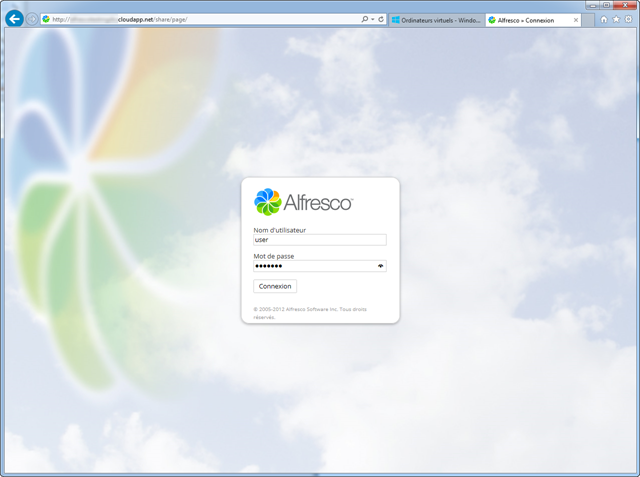

En allant dans le wiki de Bitnami, on trouve les crédentiels par défaut, et on peut donc se connecter (après bien sûr être allé sur Access my application) :

Et voilà ! Un serveur Alfresco tout propre installé avec toutes les dépendances, prêt à fonctionner, et surtout monté de A à Z en à peine un quart d’heure ! Quand je pense au temps qu’il m’aurait fallu pour créer la machine virtuelle, installer un Ubuntu, chercher comment installer un Alfresco, bidouiller jusqu’à plus d’heure avec les problèmes qui n’auraient pas manquer d’arriver, etc., je pense que je vais utiliser de plus en plus cette solution pour mes tests.

En plus, la bibliothèque est extrêmement riche : un peu moins de 300 machines à ce jour. Donc, à part si vous avez des besoins très spécifiques, vous êtes quasi assurés de trouver ce que vous voulez…