Voila, je suis dans le train, et c’est l’occasion de faire un bilan de ces TechDays. Avant, je me suis rapidement relu sur mon bilan de l’an passé (http://gouigoux.com/blog-fr/?p=117), histoire de lisser les mouvements d’humeur et de prendre un peu de recul. Malheureusement, je retrouve certains des points négatifs que j’avais déjà ressentis.

C’est l’effet démo…

S’il n’y avait qu’une expression pour résumer ces Tech Days, ça serait malheureusement “c’est l’effet démo”… Or, non, je ne suis pas d’accord, la plupart des cas étaient des erreurs qui auraient pu être prévues, ou dans lesquelles on voyait bien que la démo n’avait pas été bien préparée. Je sais d’expérience que des erreurs de connexion internet peuvent bloquer une démo, mais franchement, si je vais faire une démo d’une application sur mobile, il ne me viendrait pas à l’idée de dépendre de la 3G chez mon client : j’embarquerai le hotspot WiFi pour avoir une solution de secours.

Dans certains cas, des intervenants s’empressaient même d’accuser l’effet démo, alors que plusieurs personnes dans l’auditoire leur signalait une erreur grossière. Je comprends tout à fait que le trac lié au fait de démontrer une technologie dans un si grand évènement puisse faire réaliser des erreurs : c’est la vraie signification de l’effet démo. Mais il ne faut pas tout rejeter sur ça. Une session sur deux avec un “effet démo”, je n’y crois pas : il manque de la préparation, c’est clair…

L’inverse, c’est “magique”

Ca aussi, qu’est-ce qu’on l’a entendu… En gros, à chaque fois que ça ne plantait pas à cause de ce fameux “effet démo”, eh bien c’était “magique” ! Bon, il y a déjà l’aspect infantilisant pour l’audience qui est franchement désagréable (autant que l’accueil condescendant sur certains stands jusqu’à ce que l’interlocuteur se rende compte qu’on est MVP ou qu’on en connait finalement plus que lui). Mais surtout, ce que je trouve gênant dans ce vocabulaire est qu’il suppose que le fonctionnement de la technologie doit être caché par Microsoft. Ou bien parce que c’est tellement complexe qu’on ne pourrait pas comprendre, et qu’il vaut mieux qu’on croit que c’est la poudre de Perlin-Pinpin qui fait fonctionner le bouzin… Ou bien parce que c’est tellement simple qu’il ne vaut mieux pas nous expliquer le fonctionnement, ce qui serait gênant. J’ai tendance à pencher pour la seconde hypothèse, mais s’il vous plait, Messieurs les orateurs, ne nous prenez pas pour des idiots : on ne vous demande pas d’être révolutionnaire à chaque techno que vous inventez. Mais par contre, il faut nous expliquer comment ça fonctionne : c’est pour cela qu’on vient aux Tech Days, et nous avons la capacité, vous savez…

Orateur ou intervenant ?

Dans mes prises de notes rendues publiques sur ce blog, j’ai souvent utilisé de manière interchangeable les deux termes, mais j’aurais pu être plus strict et faire la différence entre les intervenants, qui présentent leur technologie sans faire attention à leur façon de parler, et les intervenants qui adaptent leur élocution au fait qu’ils ont un public avec une attente de clarté et de précision.

J’ai eu cette remarque en particulier sur l’élocution réellement pénible d’un intervenant, mais la remarque est d’ailleurs globale sur les Tech Days : certains orateurs sont à la limite de la vulgarité, et beaucoup ne font que peu d’efforts sur leur façon de parler. C’est certainement très bien pour “faire cool”, mais il ne faudrait pas oublier non plus que nous sommes entre professionnels. Détendu, OK, mais pas familier… Comme l’an passé, je regrette les capacités oratoires d’Eric Mittelette, Mitsuru Furuta, Bernard Ourghanlian. Presque tous les piliers de l’équipe d’évangélistes Microsoft sont très bons de ce point de vue. Ils seraient bon que ceux qui prétendent prendre la relève un jour en prennent de la graine et travaillent sérieusement leur élocution.

En même temps, je dis ça, mais je suis peut-être le seul à m’en soucier, de la même manière que j’ai l’impression de pinailler sur la grammaire française à chaque fois que je lis quelque chose de mal écrit.

Metro

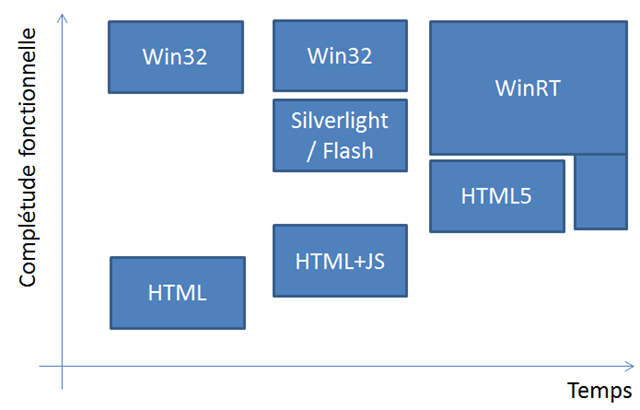

Bon, fini de me plaindre, passons aux bonnes choses parce qu’il y en avait beaucoup à ces Tech Days. Et tout d’abord, chapeau à Microsoft pour l’approche globalisante entre Metro, HTML5, WPF 4.5 et Windows 8. Je me suis rendu compte au cours de ces sessions de l’approche très scientifique de Microsoft, qui a fait intervenir des ergonomes, des designers, des spécialistes de la cognition pour arriver à une nouvelle définition de l’interface visuelle basée sur les tuiles et des réactions rapides masquant des traitements asynchrones.

Je suis toujours dubitatif sur le fait qu’on va pouvoir faire du LOB avec du HTML5, mais bon, je comprends beaucoup mieux où Microsoft veut en venir avec ces technologies. En particulier, la mise en place de la Flexbox va permettre d’avoir une bonne convergence des applications web et natives, et c’est très bien. Surtout, ceci va se mettre en place de manière plus propre que par le passé, et le fait que Microsoft soit capable de changer de manière aussi radicale (plus de bouton démarrer, plus d’icones, etc.) est assez rassurant. S’ils arrivent à réussir Windows 8 et Windows Phone 8 et unifier l’expérience utilisateur, je pense qu’ils peuvent faire de l’ombre à Apple. D’ailleurs, même l’Apple-maniaque qui m’accompagnait (et qui s’obstine à utiliser son MacBook qui ne pose que des problèmes) convient que l’interface Metro est vraiment en avance sur iOS.

Bon, en même temps, c’est un peu logique, vu que Microsoft arrive trois ans après la bataille des mobiles. Mais personnellement, cette approche ne me gêne pas. Microsoft est arrivé 10 ans après Java, mais du coup, C# est vraiment un langage propre et fonctionnel, qui a su tirer parti de son arrivée tardive sur le marché. Pareil pour tout ce qui est internet et cloud, où Microsoft avait bien loupé le virage il y a dix ans. Amazon est toujours numéro 1, mais Azure est une très bonne plateforme, qui ne demande qu’à s’exprimer. Itou pour Windows Phone.

Au fur et à mesure que je tape, je me rends compte que ça fait beaucoup de technos qui sont très bonnes, mais toujours pas numéro 1 dans leur domaine. Je ne pense pas que ça soit un manque de marketing, et je suis convaincu que la valeur technique n’est pas en cause. Peut-être que Microsoft soufre encore de sa mauvaise image, alors qu’Apple a réussi à diffuser une image angélique sans aucun lien avec la réalité… Peut-être aussi qu’il faudrait encore plus aider les développeurs à réaliser la courroie de transmission ? Des programmes comme le support actif aux développeurs pour Windows Phone ou aux utilisateurs d’Azure vont assurément dans le bon sens. Et Microsoft a un excellent écosystème de partenaires, de certifications, etc. Il ne manque pas beaucoup de support pour une adoption beaucoup plus massive !

Microsoft et l’Open Source

Un autre point très appréciable dans l’approche de Microsoft (mais ça date déjà de bien avant ces Tech Days) est la prise en compte sérieuse de l’Open Source. Autant dans les premières années on pouvait douter, en se basant sur le passé, des bonnes intentions de Microsoft, autant maintenant les choses sont claires : Microsoft a reconnu que l’Open Source était une valeur, et qu’il n’y avait aucun intérêt à lutter frontalement contre.

Les récentes utilisations “officielles” de produit Open Source par Microsoft (JQuery dans Visual Studio et MVC, Hadoop dans Azure, etc.) ou leur apport à l’Open Source (CodePlex, OGDI, OData, Samba, etc.) montrent que Microsoft s’est réellement engagé dans une voie de la coopération. Bien sûr, ça s’est passé de manière forcée, mais au moins, Microsoft a l’honnêteté de ne pas se poser en “No Evil Company”, et leur engagement est effectif.

Sessions “fil rouge”

Un très bon point également pour les sessions “fil rouge”, à savoir pour ces Tech Days toutes les sessions sur la mise en place d’une application exemple sur la gestion d’une cave à vins, et qui partait de l’architecture pour montrer le code de persistance, les services, leur utilisation dans un mobile ou une application lourde. C’est une excellente idée d’avoir mis en place ce genre de sessions avec une progression, et qui au final font voir la totalité du processus de développement, mais aussi tout le code et les astuces à mettre en place pour arriver à un produit fini. Ca mériterait d’ailleurs d’être labellisé de manière un peu plus explicite sur le programme, car seul le titre ‘”de A à Z” permettait de relier les sessions. Ca vaudrait le coup de le poser en amont comme un “parcours recommandé”. Chapeau aux intervenants de ces sessions. Pour moi, c’était les plus complètes.

Liberté des déplacements

Un petit point qui n’a rien à voir avec la technique, mais qui est agréable : le caractère moins tendu des contrôles de badges. Les vigiles demandent plus sympatiquement de retourner les badges (si Microsoft n’imprime pas le code barre des deux côtés l’an prochain, je me fais une impression recto-verso), et on peut circuler plus librement. Bref, on respire mieux…

Conclusion sur le GreenIT

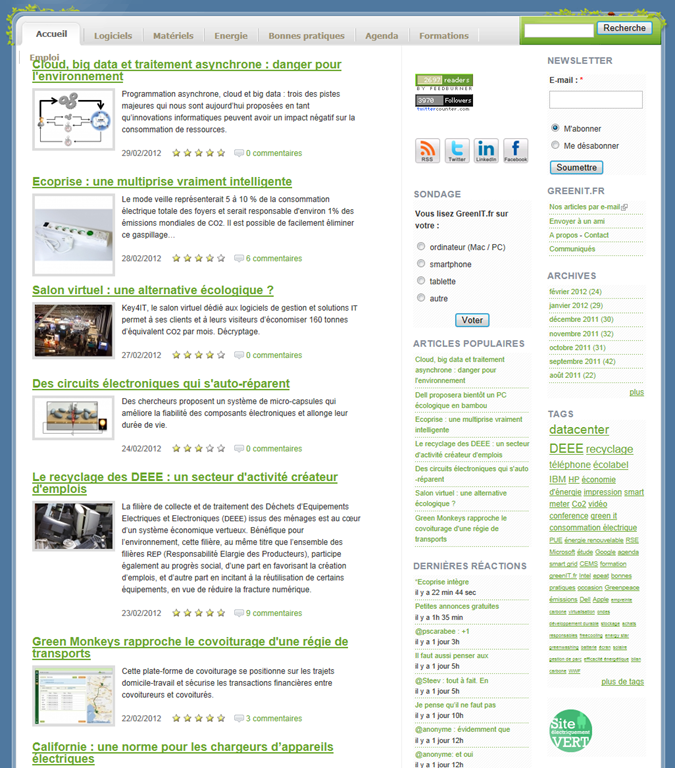

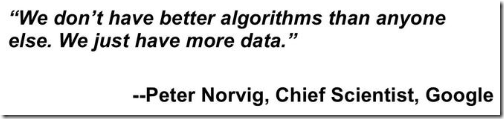

Malgré toutes ces bonnes notes, après les négatives, je finis quand même sur une touche de doute, voire de malaise. L’utilisation des approches de type Big Data et Azure sont très bien pour l’utilisateur, car elles permettent de moissonner des masses de données de manière très simple, ou de mettre en oeuvre des dizaines de machines de manière transparente.

Mais cela pose le problème des ressources. C’est un peu le problème en écologie : envoyer un mail, ce n’est rien ! On pousse juste un bouton, quelques machines traitent une donnée pendant quelques millisecondes, et c’est tout. Oui, mais il en circule des milliards par an, et à la fin, il y a quand même un impact environnemental fort. L’idée n’est pas de tout arrêter, mais d’être mieux conscient que, même si le coût est minime, il existe…

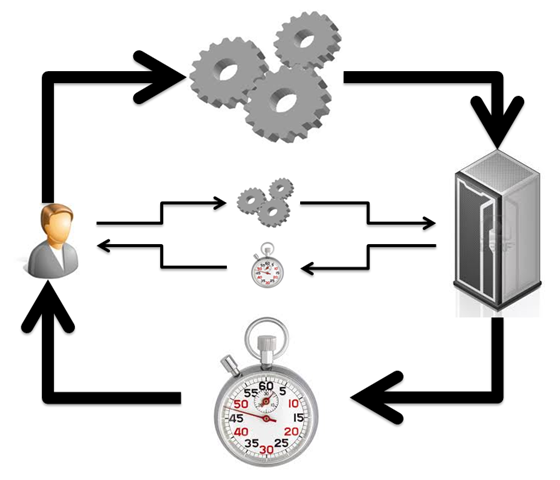

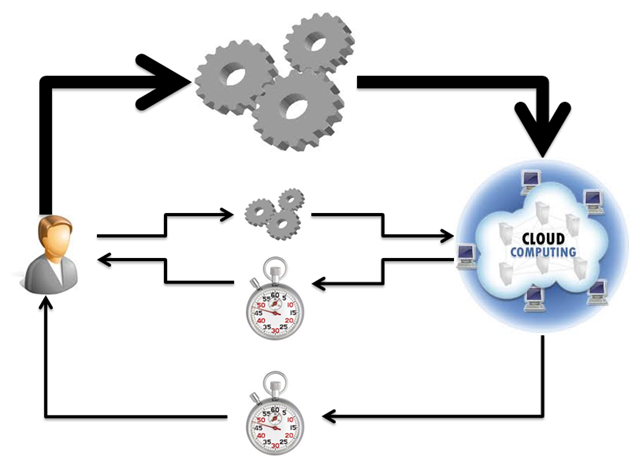

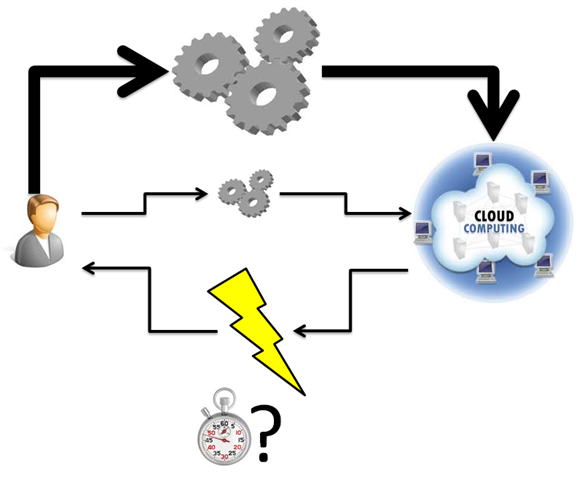

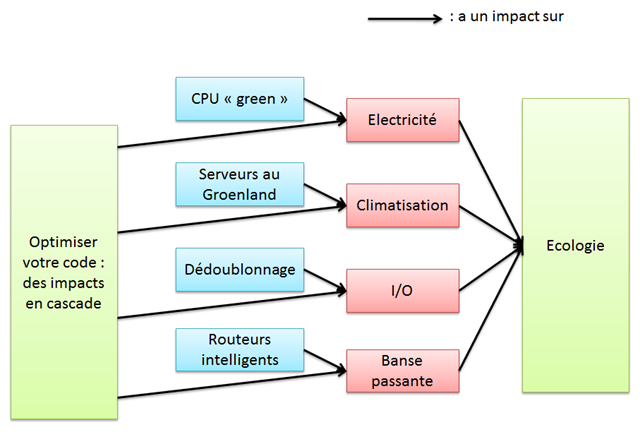

Et là, avez le Cloud et le Big Data, on risque de rendre des comportements potentiellement très consommateurs tellement transparents que l’utilisateur les appellera bientôt sans être conscient du coût environnemental. Si un analyste s’habitue à ce qu’un cluster Hadoop de 32 machines réponde en 15 minutes à des requêtes qui lui étaient inaccessibles auparavant, il va certainement demander de plus en plus de ces études. Quand une partie du traitement se faisait sur son PC, ou au moins sur des serveurs locaux aux ressources limitées, l’utilisateur se rendait un peu plus compte (ne serait-ce que par la lenteur) du coût de ses actions. Mais quand tout est déporté dans le Cloud, plus le nombre de ressources mobilisé est élevé, plus le retour est rapide, ce qui inverse cette perception ! Le risque, à terme, est que des actions simples consomment un nombre énorme de ressources. Or, comme le coût financier n’est à ce jour pas aligné sur le coût écologique, ceci se fera d’autant plus facilement que ce sera invisible. Je ne veux pas jouer les rabat-joie, mais à l’heure où on se pose la question de l’efficacité énergétique comparé de serveurs locaux ou de data centers, il faudra aussi se poser la question des comportements induits, qui peut peser lourd dans la balance. Autant, voire plus, que la qualité du code sous-jacent, qui est pourtant déjà énorme… mais méconnue.

![]()

![]()