Comme d’habitude, la plénière est ouverte en musique, avec un excellent groupe Rock, dont j’ai appris un peu plus tard qu’il s’agissait de Microsoftees. Je pensais qu’ils étaient pro, vu le niveau !

Eric Mittelette prévient ensuite rapidement qu’il faut faire gaffe à notre nuque. Je n’ai pas trop compris pourquoi, jusqu’à ce que je vois des ballons de 3 mètres de diamètre qui nous descendaient dessus ! Marrant… surtout que les premiers rangs s’amusaient à faire remonter les balles de façon que les gars qui voulaient les ranger n’arrivaient plus à les attraper. On est vraiment des sales gosses ![]()

Une analogie est faite sur toute la durée de la session entre le développement et la cuisine. Les développeurs étant comparés à des chefs, ce qui ne va pas toujours de soi, mais bon, la comparaison est correcte dans le sens où ce que nous faisons ressemble parfois à une drôle de cuisine… Par contre, il faudra éviter d’inviter des stars féminines de la télévision, parce qu’Eric Vernié avait du coup un peu de mal à se rappeler de quoi il voulait parler ![]()

Premier enseignement : désormais, tout est service. Logiciels, API, partages de documents, réseaux sociaux, etc. sont unifiables sous le concept d’un service dans le sens où il réalise un besoin unitaire d’un utilisateur ou d’un autre service. Le tout en multi-device bien sûr.

Du coup, trois points importants :

- la synchronisation multi-device, pour suivre le parcours utilisateur

- le design, pour la continuité d’expérience entre les différents devices

- la donnée comme cœur de l’application (il sera d’ailleurs beaucoup question de Big Data sur ces Tech Days

Windows Azure Active Directory : solution pour des besoins d’authentification déléguée

http://www.microsoft.fr/spark propose d’aider les startups avec une salle et des personnes dédiées dans Paris, dans le sentier. 300 m² dans lesquels chacun peut venir proposer une idée, trouver du conseil.

Eric Mittelette revient sur le mouvement Fier d’être développeur, qui démarre pour de bon cette année, avec les tee-shirt qui sont distribués, et du beau monde dans les premiers membres. Pour rappel, cette association est dans la droite lignée des mouvements comme le Software Craftsmanship, et a pour but de valoriser le travail du développeur.

Visual Studio est présenté comme le point de rassemblement unique du multi-écran (au sens écran PC ou portable, écran tablette ou smartphone, écran TV ou console). Le passage de contexte d’un mobile a un PC est montré sur un exemple d’application de choix de cocktail sur un portable, puis commande des ingrédients depuis le PC, et enfin invitation automatique par mail qui détecte l’adresse et affiche la carte sur un smartphone. Pour finir, on envoie la vidéo de la recette sur la Xbox, pilotée par la voix. La démo fait un peu artificielle, on sent que les présentateurs voulait absolument faire voir tous les devices, mais ca reste assez démonstratif de ce qu’on peut atteindre.

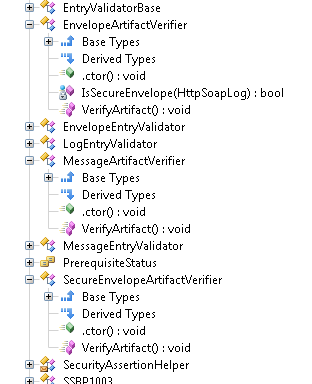

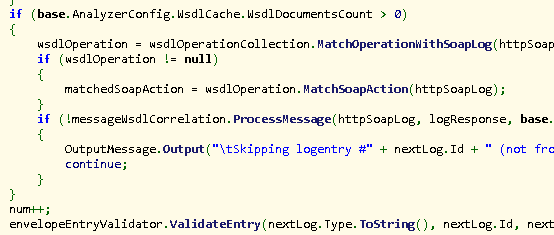

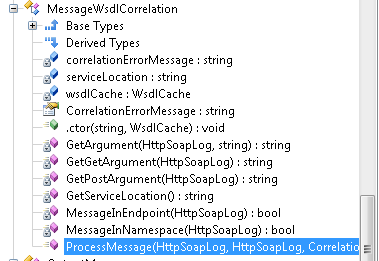

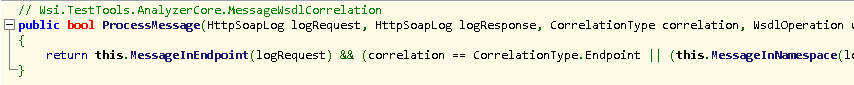

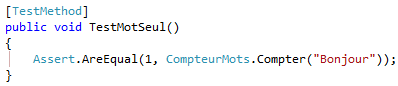

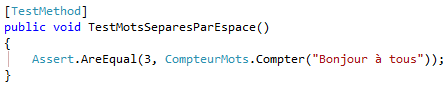

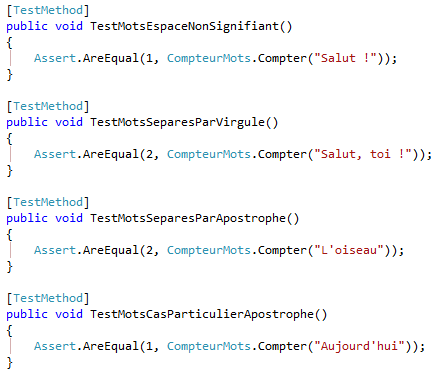

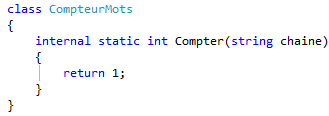

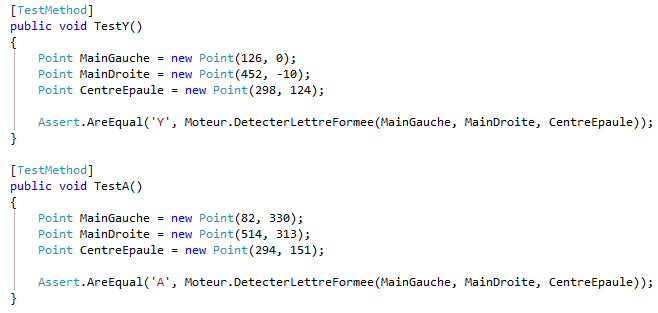

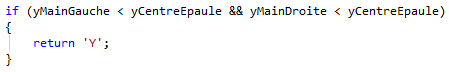

Démo du framework Fakes, et on en profite pour filer la métaphore qui a guidé la session, avec le testeur comparé au goûteur dans la cuisine. L’approche est complémentaire des frameworks de génération de mocks : l’idée, dans le cas de Fakes, est d’intercepter n’importe quelle fonction, et de la remplacer à la volée par une implémentation sur mesure dans un contexte de programmation limité par sa portée, un peu comme un using. Pour cela, le framework crée d’abord une librairie qui mime celle “faked”, et qui prend sa place dans les références. Pour ne pas trop surcharger, il est possible de restreindre les classes à simuler, sachant que par défaut, Fakes prend tout.

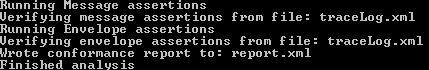

Team Foundation Service est désormais disponible sur http://www.visualstudio.com : il s’agit ni plus ni moins qu’un TFS accessible en mode service pour les petites équipes. Codeplex était déjà basé sur un TFS disponible à distance, mais là, c’est du vrai SaaS. Vraiment intéressant.

Moins intéressant (enfin, perso), HDInsight est le Hadoop sur Azure. Le projet a visiblement abouti, et est donc désormais disponible en production. Ca reste du Big Data, donc une tentative de remplacer de la cervelle par des énormes ressources matérielles, mais au moins, en mode Cloud, ça aura moins d’impact sur l’environnement car les serveurs seront simplement affectées à d’autres applications, qu’on peut espérer plus utiles.

Commandes Linux disponibles pour piloter Azure et les sites web, puis faire un déploiement depuis GitHub. Même chose évidemment dans Visual Studio en publiant après avoir téléchargé le profil de publication. Ca illustre l’ouverture de Microsoft sur les logiciels externes, et c’est plutôt une bonne nouvelle. L’intégration semble en plus très bien faite : pas de plugin ou de configuration bizarre, le lien GitHub est disponible dans l’interface par défaut. Exactement le genre d’outil qu’il faut pour démocratiser le déploiement continu des services. Encore que les outils ne sont en général pas le problème pour l’adoption de ce genre de pratique.

L’utilisation de SignalR est ensuite montrée pour recréer une application de chat. Très peu de code à réaliser. Je ne rentre pas dans le détail car je n’ai pas assez pris de notes sur ce point. Cet exemple sert de base pour démontrer l’élasticité complète de la montée en charge. La démo se poursuit ensuite sur les machines virtuelles disponibles sur Azure, qui est donc dorénavant aussi un service IaaS. VMDepot met à disposition des images préinstallées avec de nombreux OS vierges ou avec une application phare. Il est par exemple possible de trouver une image de Debian, ou une image Linux+Tomcat. De plus, la maintenance est prise en compte, apparemment, même si ça reste à vérifier dans le temps. Dans une autre session, un développeur Debian interviendra pour expliquer que la communauté Debian à participé aux modifications nécessaires pour que cet OS fonctionne dans Azure. Bref, Azure est gentiment en train de devenir aussi ouvert voire plus que le Cloud d’Amazon.

C’est ensuite un designer qui intervient, et les présentateurs insistent sur le fait que cette fonction est de plus en plus importante. Je ne peux que les approuver, étant moi-même une nullité retentissante en UI/UX. La première comparaison réalisée par le designer (je n’ai malheureusement pas noté son nom, mais nous le verrons désormais dans l’équipe des évangélistes – c’est en soi une information, ou à tout le moins un signe, d’ailleurs) est entre une application orientée colonne sur un écran PC en 16/10, et la même application correctement orientée sur une tablette Modern UI. Evidemment, on gagne de manière phénoménale en espace. A noter que le designer n’exclue pas l’utilisation du multiscroll sur mobile. Jusqu’à maintenant, j’avais toujours entendu dire qu’il fallait se limiter à une seule direction de scroll, mais bon…

Un nouvel acronyme, les applications SOLOMO, pour SOcial + LOcale + MObile. Démo d’après insistant sur la personnalisation de Windows Phone 8, en passant de l’information sur l’écran de verrouillage ou d’accueil, ce qui encourage l’utilisateur à aller plus souvent sur l’application, ou en tout cas lui facilite la vie pour être au courant sans avoir à chercher activement l’information dont il veut avoir connaissance. C’est là qu’on voit que des ergonomes ont bossé sur ModernUI.

WalletTransactionItem est la classe pour piloter le portefeuille dans WP8, et WalletAgent est celle qui permet de mettre à jour en mode push. Pour le NFC, on déclare simplement un protocole de type monappli:// dans le manifeste d’application.

Il y a désormais un objet JsonArray pour lire du JSON depuis .NET, donc plus besoin d’API externe comme JSON.NET, d’après ce que j’ai compris.

Au final, une bonne session bien orientée développeurs, comme toujours pour le premier jour des Tech Days, la seconde étant plutôt dédiée aux IT, et la troisième aux décideurs, ce qu’on constatera encore une fois en cette septième édition des Tech Days.

Un lien sur un VRAI site, pour un compte-rendu de VRAIS journalistes : http://pro.clubic.com/it-business/cloud-computing/actualite-540886-techdays-2013-tfs-microsoft-cloud-services-developpeurs.html